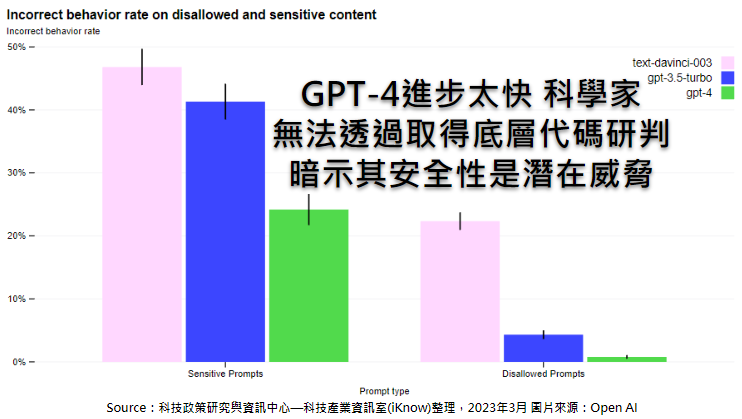

GPT-4進步太快,科學家無法透過取得底層代碼研判,暗示其安全性是潛在威脅

科技產業資訊室 - 友子 發表於 2023年3月21日

圖﹑GPT-4進步太快,科學家無法透過取得底層代碼研判,暗示其安全性是潛在威脅

ChatGPT所依賴的的大型語言模型的最新版本GPT-4發佈了。與GPT-3.5相比,GPT-4能夠根據任何提示創建類似人類的所做的文章、產生影像和電腦程式碼。

研究人員表示,GPT-4的這些能力有可能改變科學,但有研究人員表示,他們還無法接觸到這項技術、其底層程式碼或如何訓練的資訊,所以不能判斷其安全性如何,甚至未來是否對人類帶來威脅。

最新版本的GPT-4的一個升級之處是,不只能處理文字對話還可以處理影像。OpenAI表示,GPT-4以第90個百分位的成績通過了美國律師法律考試,這比起GPT-3.5版本的ChatGPT僅通過第10個百分位有很大進步。

其實,GPT-4還不能被廣泛使用,只有ChatGPT的付費用戶可以使用最新版本。

荷蘭阿姆斯特丹大學的心理學家表示,看過GPT-4的演示之後,對其能力感到驚歎。例如:GPT-4可以僅僅根據一個網站的手繪塗鴉圖像,快速生成建構該網站所需的電腦程式碼。

科學界對於OpenAI對模型如何訓練、訓練哪些數據以及它實際如何工作的保密感到沮喪。因為他們並非是開源模型,屬於封閉模式,整個AI社區來說,這是一條死胡同。

一位Rochester大學的化學工程師是Red Team的身份,所以可獲得訪問GPT-4的特權。基本上,Red Team是OpenAI雇來測試GPT-4平台並試圖讓它做一些壞事的人。他發現單獨使用GPT-4的效果可能沒有多麼出色,但當你讓它連接網路之後,它就像突然擁有了新的能力。所以他的擔憂是,例如:GPT-4可從網路獲得製造危險化學品的機會,如果沒有人規範,其可以從事危險、非法或破壞性的東西。事後雖然OpenAI的工程師對GPT-4模型進行了調整,但其仍受到質疑。

GPT-4還面臨著一個問題,那就是輸出虛假資訊,像GPT-4這樣的模型,可以用來預測句子中的下一個詞,但無法判斷虛假或錯誤資訊,進而預測錯誤的「幻覺」。

簡單來說,由於無從得知GPT-4的訓練資料,OpenAI對於安全性的保證並無法滿足科學界的要求,這讓人們無法監督GPT-4所犯的過錯。如果科學家不能存取GPT-4背後的程式碼,就不能看到偏見從何而來,也就無法糾正產生的偏見。

科學家們還擔心,最後這些AI技術將集中往某些科技大廠,希望這些科技大廠能負起責任,讓科學家進行適當的測試和驗證,但是在商業利益且尚未發生重大事件的前提下,根本很難執行。

總之,儘管科學家存在許多質疑,但可預見GPT-4及其未來版本將繼續撼動科學,有可能像網路改變科學一樣,成為下一個改變科學的力量。短時間來看,GPT-4們是不會取代科學家的,卻能夠協助他們完成一些任務。到底生成式AI會走到哪一步,只能祈求它不要走偏了。(941個字;圖1)

參考資料:

GPT-4 is here: what scientists think. Nature, 2023/03/16.

相關文章:

1. AI自動生成內容非人類所寫 – 是否可享有著作權?——權利保護資格篇

2. 元宇宙時代中AI之12個主要發展趨勢(中)

3. 在ChatGPT和Bard風潮下,蘋果會將生成式AI帶入其生態體系嗎?

4. AI聊天機器人ChatGPT引爆著作侵權疑雲?——文字篇

5. 人工智慧(AI)可能從2023年起,徹底改變市場遊戲規則

6. ChatGPT劍指智慧手錶和電動車領域,蘋果和特斯拉都將面對

--------------------------------------------------------------------------------------------------------------------------------------------

【聲明】

1.科技產業資訊室刊載此文不代表同意其說法或描述,僅為提供更多訊息,也不構成任何投資建議。

2.著作權所有,非經本網站書面授權同意不得將本文以任何形式修改、複製、儲存、傳播或轉載,本中心保留一切法律追訴權利。

|