圖、Midjourney與Stability AI擴散模型自動生成引爆著作侵權疑雲?——圖形影像篇

近半年來,不論在網路上的搜尋量、新聞媒體熱度,抑或是研討會的主題,只要和ChatGPT或「生成式AI」(AIGC: AI Generated Content自動生成)扯上關聯就有討論不完的話題,這也連帶地牽動AI對未來產業的新興變革。2021年6月,OpenAI發表了一篇標題為「Diffusion Models Beat GANs on Image Synthesis」(擴散模型在影像合成上打敗對抗式生成網路)之論文,內容中的「Diffusion Model」(擴散模型)是自動生成文句、圖像、音樂的要角,本文將先從擴散模型運用到文字生成圖像的整體架構,做簡單的說明,然後論及目前所衍生著作權抄襲侵害方面的法律議題。

製作經營桌遊工作室 Incarnate Games的Jason Allen,2022年透過Midjourney創作了一幅超逼真的圖像作品《太空歌劇院》(Théâtre D’opéra Spatial)畫作(見圖一),在美國科羅拉多州博覽會的藝術競賽中,獲得數位藝術類別藍絲帶首獎。儘管該作品是由AI創作,並非作者自己一筆一劃繪出,但是該作品饒富巴洛克風格,令人難以相信這是由AI自動生成的畫作。

圖一、Midjourney創作《Théâtre D’opéra Spatial》來源:Jason Allen via Discord

一般來說,目前AIGC廣被應用的模型可分成兩大類,一種是藉由文字指令提示(prompting) 就可生成圖像的AI模型,例如目前最為為熟知的Midjourney、Stable Diffusion、DALL-E2或Google Brain;另一種則是藉由提示圖像來生成文字的AI模型,例如CLIP(Contrastive Language-Image Pre-Training,這是一種對比學習,將圖像與文字做連結後進行預訓練,待下一張新的圖像輸入至CLIP後,CLIP就能根據圖像中的情境去「看圖說故事」)。

基本上,後者比較不會有爭論,因為要從圖像自動生成一段短文,基於其所進行之網路上的文字接龍,在著作權法允許參考他人「概念」卻做出不同「文字表達」情況下,似可稀鬆平常地用不同內容的一段話來表示,所以相對較不致有模仿或抄襲的爭論(參本刊之前曾報導:AI聊天機器人ChatGPT引爆著作侵權疑雲?-- 文字篇)。然而,目前爭議較多的是前者,因為生成的圖像,大部分來自在網路上曾公開出現的圖片,而將其做為訓練集所生的結果,圖片本身經AIGC處理雖非單純複製貼上的運作,但在布局、感觀、結構上,仍可能「殘存」某種程度上的「關聯性」,故可能衍生「整體風格上」之相似度,而導致抄襲模仿之爭論。美國日前爆出幾位藝術家對AI自動生成圖像工具供應商:Stability AI(開發Stable Diffusion圖像軟體)、Midjourney和DeviantArt三家公司起訴,指控這些被告用擴散模型(Diffusion Model)來訓練其AI機器學習,侵害彼等之著作侵權,就是此種類型。

AI擴散模型自動生成之技術介紹

任何的AI模型訓練都會經過編碼的程序,因為對電腦而言,它只懂0與1所組成的數位資訊,或者說它只讀取數值型態的資料。若單純地給予電腦成千上萬張的原始圖像作訓練,電腦是無法讀取或運算的,更別提會有「歌劇院畫作」。因此,AIGC第一步就需要對圖像編碼。關於編碼請參考圖二,茲先介紹一種名為自動編碼器(autoencoder) ,用於非監督式學習的類神經網路。

圖二、自動編碼器(autoencoder) 的架構圖

來源:筆者自繪

自動編碼器的目的在於,輸入端的圖像(如圖二中所示的黃金獵犬)與在輸出端的重建圖像實質上應一致或相似。可惜事情沒想像中那樣簡單,如只是單純輸出就等於輸入的結果,那就失去設計自動編碼器的意義。原來資料科學家是利用它來降低資料維度並提取特徵,其功能類似於特徵工程中的PCA(principal component analysis,主成分分析),雖說中間過程可能造成有損資料壓縮(lossy compression),但這樣反而更能降低如記憶體、運算複雜度等訓練成本,而且增設自動編碼器做AI模型訓練的效果比PCA來得更好,這也是它在深度學習的領域中,始終扮演不可或缺的角色。

而當輸入一張黃金獵犬圖像後,由於電腦本身不懂圖像的意義為何,所以此時需要透過編碼器,來處理黃金獵犬圖像中的每個像素(pixel),好讓電腦對每個像素做讀取與運算,所以需將每個像素做編碼,而這編碼就是電腦最擅長處理的數值型態之向量,例如像素X1 = (1,0,0,0)、X2 = (0,1,0,0) 、X3 = (0,0,1,0) 、…、Xn = (0,0,0,1),當然這只是簡單舉例,實際編解碼的運作包含機率分布等極複雜的數學問題,就不在此一一說明,讀者們只要掌握AI的運作概念即可。至於為何要將每個像素編碼成為數值型態之向量?其實概念上,就是利用「餘弦相似度」(cosine similarity),去找出哪些圖像與使用者所輸入的語義最相似,若餘弦值等於1就判斷為最相似,若等於0就判斷為最無關,也就是說,餘弦值越接近1就代表兩者越相似。

重點來了,經過編碼器之後就開始透過類神經網路的訓練,然後再將運算後的資訊,映射至一潛在特徵空間(latent feature space),好讓圖像特徵與權重(weight)等資訊保存。也就是說,在潛在特徵空間的資訊雖然都被壓縮,但卻能代表輸入之前原始圖像的大部分資訊,這將使得解碼器對潛在特徵空間的資訊進行解碼時,可用低成本訓練,並重建與原始圖像相似的圖像。

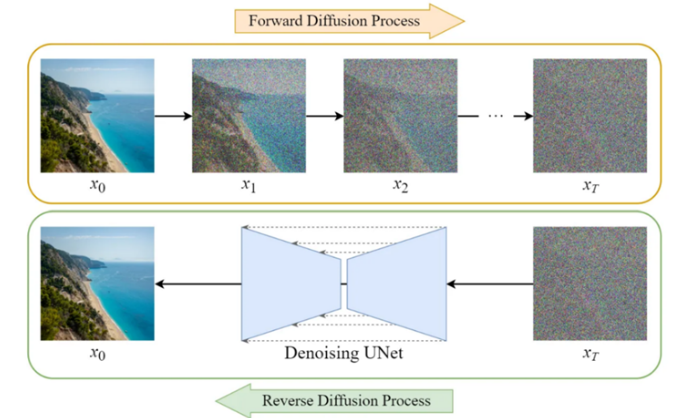

接著,就進入擴散模型的精隨,請見圖三。假設圖三中的原始圖像X0為64*64像素,進行擴散模型時可分為二大階段。首先,執行所謂的「向前擴散過程」(Forward Diffusion Process),即原始圖像X0透過加入高斯雜訊後,陸續形成圖像X1、X2、…、XT,也就是說,原始圖像X0會越來越模糊,直到成為圖像XT,此時肉眼幾乎已看不清原始圖像X0的面貌;接著,再進行所謂的「逆向擴散過程」(Reverse Diffusion Process),其目的不僅是為了去除雜訊,將圖像XT重建回原始圖像X0,而且還可提升比原始圖像X0還要高的畫質。

許多人可能難以理解為何加入雜訊後,不僅可以還原圖像,而且畫質反而更好。試想一種情境,讀者自己就是AI,在進行「向前擴散過程」時,當你看到一隻黃金獵犬,此時若拿一張霧面玻璃置放在你和黃金獵犬之間,想必可輕易辨識出該霧面玻璃後就是黃金獵犬;若再拿第二張霧面玻璃置放其間,你也許還可辨識出二張霧面玻璃後是黃金獵犬,只是辨識開始略為吃力;以此類推,直到你和黃金獵犬之間被放置N張霧面玻璃後,你將越來越難辨識N張霧面玻璃後的物件,但經過前面多次的辨識經驗,你隱約可以根據影子的輪廓、大小、深淺等「特徵」辨識或猜測出N張霧面玻璃後的物件就是黃金獵犬。

至於進行「逆向擴散過程」時,基本上就是對AI驗收學習成效,有點像是對AI下一道考題:「請根據剛剛辨識特徵的經驗,學著用自己理解的方式畫出來」。需說明的是,就擴散模型的數學理論而言,AI真正進入學習階段是在「逆向擴散過程」,這時的AI開始「臨摹」上一階段所學習到辨識特徵的經驗,然後開始自動生成與原始圖像相似的圖。甚至於,透過一些參數的調控可決定生成圖像的相似度,當然這樣生成的圖像也可脫離原始圖像的內容,即便新生成的圖像內容可能與原始圖像不太相近,但仍會殘留原始圖像的風格[1]。

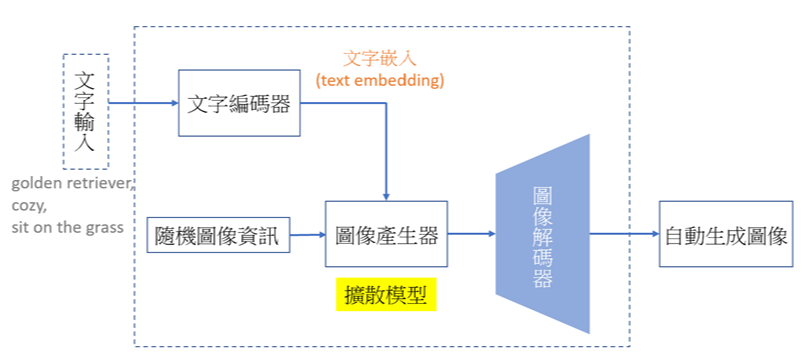

圖四為擴散模型應用在文字生成圖像的示意圖。透過使用者輸入的指令,例如golden retriever, cozy, sit on the grass(黃金獵犬、愜意、坐在草地上)等文字,輸入至文字編碼器並進行文字嵌入(text embedding),將文字轉成數值型態之向量後,再傳送到圖像產生器。此時的圖像產生器根據該文字嵌入,並從已經學習過的成千上萬張與golden retriever, cozy, sit on the grass等文字有關的圖像中,自隨機圖像資訊中隨機抽取,接著圖像產生器利用擴散模型去抓取和golden retriever, cozy, sit on the grass等文字對應相關的圖像後,透過加入高斯雜訊與去除高斯雜訊後進行圖像的自動生成,最後將其擬合後的結果,透過圖像解碼器自動生成「黃金獵犬愜意地坐在草地上」之圖像。需特別說明的是,透過使用者所輸入的文字指令提示抓出的各種圖像,對AI來說都各自對應一機率分布,透過運算多種機率分布後,擬合成「黃金獵犬愜意地坐在草地上」這樣圖像。當然,這樣新生成的圖像不僅可能與原始訓練樣本的內容有所不同,而且影像品質還會更豐富銳利。這也是OpenAI為何發表「Diffusion Models Beat GANs on Image Synthesis」(擴散模型在影像合成上打敗對抗式生成網路)論文之原因。

圖四、擴散模型應用在文字生成圖像的示意圖

來源:筆者自繪

順便一提,有些專家會將其和「變分自動編碼器」(Variational Autoencoder,以下簡稱VAE)做連結,二者都是基於學習數據的機率分佈,並從該分佈中生成自動生成圖像。不同的地方在於,VAE將數據編碼為一個低維的潛在特徵空間(如圖二所示),並進行各種如插值或向量運算,儘管VAE容易做模型訓練,但生成的結果往往不太理想;至於擴散模型,並不直接產生一個潛在特徵空間,它是透過加躁的前向過程與去躁的逆向擴散過程,達到自動生成圖像,這種方法通常能產生非常逼真的圖像。

AI擴散模型自動生成著作侵權之法律判斷

大致介紹完擴散模型與文字圖像自動生成的原理後,緊接著來討論這些新興科技的背後所衍生出的法律爭議(本刊之前曾報導:OpenAI與微軟之ChatGPT AI自動生成引爆著作侵權疑雲?-- 開源碼軟體篇),而其中最令人驚艷的,莫過於以文生圖或以圖生文這樣的AI工具,讓使用者輕鬆透過指令提示,產生其想要的圖形影像,用在工作和娛樂方面。但是隨著Midjourney、Stable Diffusion等知名圖像生成工具廣受世人使用以來,這其間也衍生了藝術家控告Stability AI和Midjourney侵害其著作權的訴訟案件(Andersen et al v. Stability AI Ltd. et al),但本案最具爭議的是,原告於起訴狀中承認:為回應特定文本提示,Stable Diffusion所生成的圖像,通常不會與原訓練資料中的任何特定圖像完全匹配,這是因為在生成過程中,使用條件資料來插入多個潛在圖像,因此生成的混合圖像,不會與訓練資料中任何被複製的圖像完全相同,故而是侵犯及原告畫家的「風格」,以下就加以介紹。

眾所周知,要讓AI機器學習能夠理想地被應用在實際場景,當然需要不少的訓練樣本,而這件侵權訴訟中最備受爭議的,當然就是利用原生文字和圖像等訓練樣本所自動生成的文字或圖像。雖然到目前為止,ChatGPT和Midjourney等工具提供者都未揭露,其究竟係如何取得訓練資料後建立dataset?一般合理推測是,他們應該是利用網路爬蟲(web crawlers)擷取技術,抓取公開的大量資訊內容;其次,它又如何自動生成文字與圖像?根據前述的擴散模型,讓AI透過已取得的訓練資料集而反覆自我學習,然後自動生成文字或圖像。

Google Search Engine與書本搜尋資料庫

先談第一點其如何取得訓練資料集。理論上,生成工具開發商可透過付費方式,向各資料庫供應商獲取素材。然而,眾所周知,生成工具開發商難以向所有各式各樣的數據源資料供應商採購,這是基於成本考量,所以許多知名科技公司捨棄透過正規的採購管道取得授權,而是直接利用網路爬蟲技術,從網路上擷取各種資訊,雖然未必是最有效率的數據取得方式,但這畢竟是最省成本的方式。

然而,未經授權在網絡上大量使用他人具有著作權的資料,是否即構成著作權侵犯,仍需要進一步檢驗。換句話說,未經同意使用他人的資料不一定立即違法,關鍵在於使用者對他人素材的再利用後,最終呈現的內容是否構成侵權。針對此,大家最熟悉的例子之一,就是二十多年前的Google搜尋引擎。當時Google的做法,就是在網路上收集大量資料,然後透過提供URL(Uniform Resource Locator)連結的方式,將瀏覽者引導進入特定網站,以查看他們所需的資訊。

依照Google搜尋引擎的運作模式,雖然在運作過程中涉及大量的資料重製,但在重製完成後,通過提供URL連結的方式,該網站並未留存包含具有著作權之「表達性的內容」。因此,這種運作模式實際上,反而是幫助讀者更方便地進入原始內容的網站瀏覽。雖然這種模式涉及中間過程的複製行為,但最終呈現的結果並不侵犯著作權。類似的情況也出現在資料探勘中,使用者收集各種資料,但最終的呈現方式,可能同樣不會導致侵犯著作權的結果。

以機器學習方式進行語料資料庫學習過程是否違反著作權法?美國作家協會(Authors Guild of America)與多名作者於紐約聯邦地院控告Google,指控Google Books corpus之搜尋引擎資料庫(Google Book Search Database),未經授權重製掃瞄數百萬有著作權書籍,以增強其Google Books自然語言處理(natural language search),透過顯示關鍵字搜尋之「Snippet View」運作,會秀出環繞在所搜索字詞旁之原文內容,讓讀者看到書中部分文字片段,已構成著作權鉅大侵害。但2015年美國第二巡迴上訴法院全部法官同意,Google創設之數位化書籍搜尋引擎功能,縱使未經授權亦未付費,但Google Books為作者提供一種途徑,幫助潛在讀者了解並找到該作品,不僅促進知識擴散之公共利益,更可增加讀者數量,提供連結讓讀者易於找到該作品增進書籍銷售,從而為作者帶來利益,其複製書中內容行為屬於高度轉化性目的(highly transformative),故屬於「非侵權之合理使用」。簡而言之,因為複製後簡示之結果構成合理使用,因此其前段中間過程之複製即毋庸再議了。

重點在最後呈現的結果而非中間複製行為

這些例子顯示,當業者提供新科技的產品或服務時,即使在過程中確實存有他人著作的重製行為,但是否違法端視最後呈現的結果,是否形成對資料合理使用的情形,例如可促進人類文化知識擴散或達到公共利益來決定。也因此,在評估AI自動生成工具時,其運作過程中所進行的中間複製行為,似乎就不是法律應關注的重點,而必須將焦點集中在最終呈現的結果上。

其次來談,其係如何自動生成文字與圖像。擴散模型自動生成內容的情況是否構成侵權,在法律上尚待檢驗。在本件藝術家所提出的集體訴訟中,原告指控Midjourney等未經授權使用其具著作權的大量畫作,做為被告AI機器學習的素材。然而,本案與一般的著作侵權案件有所不同,因為大部分侵權案例中,原告必須證明被告實際上,究竟抄襲了原告哪些作品的哪些部分,需要進行比對以確定二者之間是否存在「實質相似性」,從而判定其是否侵權。基於前述的擴散模型的運作方式,透過高斯函數加入高斯雜訊和去除高斯雜訊,從正向再到逆向過程中以AI機器學習藉此提取特徵,該擴散模型可將所有蒐集的相關圖像素材「打散重組」,並掌握原生素材的特徵後,再揉合重新自動生成新的圖像。

擴散模型與風格上之近似

然而文題是,這些新圖像與被作為訓練樣本的原生素材,不會構成完全相同或近似,只能說本質上提取了訓練樣本的許多特徵,導致擴散模型操作下所生成的新圖案,在風格上產生所謂的近似,但這種「風格上的近似」,並不是具體基於圖畫中哪一部分在「一對一」比較下構成相似,而是就整體呈現「感觀上之風格近似」!因此,這正是本案中的重要爭點,即最後呈現的結果是否構成侵權,不是基於比對的實質相似性。法律上對於這種創作過程中的複製行為,是否構成侵權?還需要進一步檢驗。

正因為如此,即使原告藝術家的律師在起訴狀中未能具體指責,被告自動生成工具所產生的圖像中,究竟哪幾幅與原告創作之哪幾幅繪畫作品,可一對一點出二者類似之處,反而只能抨擊被告之工具生成內容,在「風格上」與原告作品產生雷同!這是因為被告生成工具將各藝術家所有的作品,透過擴散模型運作產生與該畫家近似之獨特風格,亦即使用者只需提供該畫家的名字作為指令提示輸入,AI便能自動生成該畫家風格的畫作,這種風格上的相似性,已經使傳統繪畫抄襲的概念產生了質的變化。在新興科技發展的背景下,這對於著作權應該涵蓋的範圍和保護內容產生了重大挑戰。

我們可以這樣理解,以往原被告的系爭畫作究竟是否造成實質相似,其實都可以進行客觀具體的比對分析。但對於AI機器學習與擴散模型所產生的作品而言,系爭畫作所謂風格上的模仿,可能就難用一對一比較來評斷各項元素或其組成是否相同,況且,風格本身是否受到著作權保護?各國司法實務上並不確定。一般而言,各個畫家都有其獨特的風格,但風格本身是一種抽象的描述。按著作權和專利有著基本原理上的差異,專利講求「只此一家、別無分號」的絕對壟斷;而著作權卻是站在推廣文化的角度,允許大家可參考別人的概念或構想,來創作出基於相同概念、但具有實質不同之表達的內容結果,從而促進人類的文化發展。

因此,各國的著作權法都會規定,人類思維的構想或概念本身,並不是著作權法要去保護的對象,而必須是作者根據該種概念具體書寫或畫出實際內容,才受著作權法保護。基於此,著作權法規定其保護僅及於該著作之表達,而不及於其所表達之思想、程序、製程、系統、操作方法、概念、原理、發現,而在這種情況之下,可能有些人會認為,所謂風格也者,或許應落入思想、概念,而不是著作權法應該要去保護的對象!

然而,是否可以將所謂之風格,一竿子打入所謂不受保護的範圍,這是值得商榷的!因為所謂的繪畫風格,是指畫家個人藝術表達的總體特徵,以突顯該畫家的辨識度和獨特性。它是畫家在創作過程中運用筆法、構圖、線條、色彩、光影、比例、角度、空間透視和筆觸等繪畫元素的獨特運用方式,形成其個人美學上獨具特色的表達。這種風格完整體現了畫家的總體藝術觀念、情感表達和個人經驗,並呈現出其對審美的獨特而鮮明的詮釋。同時,也反映出畫家內在涵養與個性的綜合體現,使人能一望即可辨認係出自何人之手。其成為觀者欣賞、理解和評價其畫作的重要指標,並為作品賦予獨樹一幟的標誌性意義和價值。

風格上近似之著作侵權議題

我國智慧財產法院,雖未直接就作品的風格是否受著作權法保護表達見解,但依其實務上的觀點,不論就作品之風格特徵、表達風格和創作風格等都可作為評估之參考因素。而在判斷是否構成侵權時,法院對兩造爭議的著作所進行之比對,亦可能包括整體風格、特定段落之編輯方式是否相同來認定;甚至在個案中法院認為,會考慮一般設計者常有的處理方式,例如特殊物件的實際應用、相對抽象風格呈現方式、物件的擺設位置以及其他物件之間的相對位置和關係等,都是判斷是否存在抄襲的重要因素;甚且,縱使二造都採用相同的風格設計,但如在描繪圖案設計細節和所傳達給讀者的整體感受上存在明顯差異,兩者即不構成實質上的近似。

在這種情況下,風格的呈現會連動到作者在其作品所呈現重要元素,例如針對繪畫中的佈局或安排、色彩的運用、畫作的結構、組成和各元素彼此間所呈現的互動或安排等,都會反映出作者的獨特風格,因此,如有人將作者構圖中不同元素,用不同的內容來替代轉換,但在整體感官上,如殘留該畫家既有可表現出其作者屬性、特徵或相關組成及各元素間的相互安排關係時,此時可否據而認定這些呈現風格的元素、佈局、安排、結構、組成等都不受著作權保護,就有商榷的餘地!

因此,在評估著作權是否構成侵害,似不應一概而論地將所謂的風格,速斷認為是不受保護的構想或概念加以摒除,而必須依具體個案來做實質的判斷,也就是說,當原告指控被告在「風格上」與其近似時,那就必須讓原告來舉證,究竟其哪些風格之內涵與被告遭指控的內涵,二者間存在相似度,按照著作權法原則,具體衡量二者之間是否構成實質相似進行比對判斷,如原告未能具體一一指控系爭風格的元素,則徒然空言係風格上近似云云,自然無法取得勝訴。換言之,最終仍應針對具體之侵權個案來判斷 (case by case basis)。而美國案例法上,基於風格近似較屬抽象正反看法都有,當然也看個案事實中風格究何所指再予認定。

總之,擴散模型的問世,帶來了新興科技對於著作權傳統判斷原則的挑戰。在法律上應如何處理這些挑戰,除非進行相應的法律修訂,否則需要法院根據現行法規範予以審慎處理。因而本案日後之判決結果,備值關注。(7454個字;圖5)

註解:

作者資訊:

陳家駿 台灣資訊智慧財產權協會 理事長

許正乾 因子數據股份有限公司 共同創辦人

參考資料:

Doersch, Carl. "Tutorial on variational autoencoders." arXiv preprint arXiv:1606.05908 (2016).

VAE:變分自編碼器學習筆記

3. Diffusion Model Clearly Explained. Medium, 2022/12/26.

Diffusion Models Beat GANs on Image Synthesis, OpenAI - Dhariwal et al., 2021

Andersen et al v. Stability AI Ltd. et al, Docket No. 3:23-cv-00201 (N.D. Cal. Jan 13, 2023)

Benjamin L. W. Sobel, Artificial Intelligence’s Fair Use Crisis

Matthew Stewart, The Most Important Court Decision For Data Science and Machine Learning. TowardsDataScience, 2019/11/01.

智慧財產法院107年度民著上字第16號、107年度民著上字第4號民事判決、109 年度民著上字第 19 號民事判決

相關文章:

1. 最新專利顯示,蘋果想在AirPods耳機盒增加觸控螢幕,可能讓iPod起死回生,創造新市場

2. OpenAI與微軟之ChatGPT AI自動生成引爆著作侵權疑雲?——開源碼軟體篇

3. AI自動生成內容非人類所寫 – 是否可享有著作權?——權利保護資格篇

4. AI聊天機器人ChatGPT引爆著作侵權疑雲?——文字篇

5. 從最新專利顯示,蘋果仍對於蘋果手錶配備相機功能充滿期待

6. 針對聯想訴訟案,倫敦高等法院判決:FRAND權利金金額遠低於InterDigital公告的權利金費率

--------------------------------------------------------------------------------------------------------------------------------------------